StorPool pousse les performances flash sur Infiniband, RDMA et Ethernet

Solution de stockage bloc en mode distribué, StorPool est capable de fournir plus d'un million d'IOPS par serveur et des temps de réponse inférieurs à la milliseconde avec des SSD NVMe.

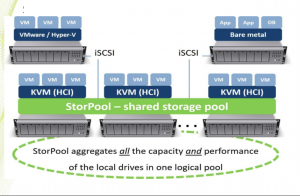

Depuis notre première rencontre en 2014, la start-up bulgare StorPool a affiné sa stratégie et peaufiné son système de stockage distribué en mode bloc (sur des clusters de serveurs x86 sous Linux avec un réseau Infiniband, RDMA ou Ethernet 10G) et se positionne désormais comme une solution de type SDS 2.0. On l'oublie souvent, mais les architectures de stockage et les systèmes de supervision reposent sur des technologies particulièrement complexes qui ne vont pas en se simplifiant avec la montée en puissance des solutions hybrides (locale et cloud). Storpool entend moderniser cette couche d'infrastructure avec une approche hybride (local et cloud, mais aussi HDD/SSD) capable de concurrencer efficacement les plateformes SAN, AFA et autres. Un cluster de serveurs StorPool agit comme un pool de stockage qui peut être présenté comme une plate-forme de stockage dédiée ou une solution hyperconvergée. Storpool présente ainsi des volumes de stockage en bloc à VMware eSXi et Hyper-V via le protocole iSCSI .

Bare-metal VM ou et containers sont aujourd'hui supportés par la solution de stockage de StorPool pour exécuter des applications et services dans un environnement sécurisé avec tous les avantages de la technologie définie par logiciel (SDS) . « Nous sommes très rapides et très solides », avoue sans ambages Boyan Ivanov, CEO et cofondateur de Storpool, « avec une approche cloud native et un support multistack: OpenStack, OpneNebula, KVM, VMware, Hyper-V et bare-metal... ». Les clusters de serveurs sous Linux exploitent un protocole maison - la sauce secrète de la startup - baptisé Storpool Block pour afficher des performances d'un million d'IOPS par serveur et des temps de réponse inférieurs à la milliseconde avec des SSD NVMe. Storpool fournit également un pilote (StorPool Block Device) pour les noeuds client (KVM, OpenVZ, Docker/LXC) accueillant les applications et les bases de données. Basés sur Linux, les noeuds clients prennent en charge les systèmes de fichiers XFS, ext4, ocfs2 et GFS2. Le pilote de périphérique bloc est installé en tant que / dev / storpool / * sous Linux, et se présente comme un périphérique bloc pour les systèmes de fichiers et les applications. Point important, chaque client Linux accède en parallèle au pool de stockage partagé, interagissant avec le service du serveur StorPool dans chaque noeud du cluster. C'est une approche très similaire à plusieurs technologies HPC telles que Lustre et BeeGFS, où le pilote côté client contrôle les E / S vers les noeuds de serveur du cluster. Ces performances élevées sont obtenues grâce à un accès direct aux lecteurs NVMe et aux cartes réseau (SR-IOV) qui contournent le noyau Linux. C'est ce qui donne à StorPool un avantage en termes de performances par rapport aux autres plates-formes de stockage définies par logiciel.

Intégration native avec K8

StorPool assure également une intégration native avec les clusters Kubernetes à travers laquelle des volumes persistants sont fournis aux pods. Cela garantit que les clusters Kubernetes sur site utilisent un stockage persistant pour leurs conteneurs avec des bases de données ou des applications et microservices. Storpool n'a pas besoin de noeuds dédiés et peut s'exécuter sur des serveurs x86 - dans ce cas, Kubernetes et StorPool fonctionneront sur les mêmes machines. Pour intégrer StorPool à Kubernetes, le module Kubernetes StorPool doit être installé sur tous les noeuds. À la fin de l'installation, toutes les machines hébergent à la fois un cluster Kubernetes fonctionnel et un cluster de stockage StorPool. Les deux logiciels fonctionnant ensemble pour fournir un système permettant d'exécuter et de gérer des applications conteneurisées et de fournir un stockage persistant pour leurs données. La compatibilité native de StorPool offre un gros avantage par rapport aux autres solutions de stockage, car Kubernetes a des exigences très spécifiques concernant l'allocation des ressources système, de sorte que la pratique habituelle pour Kubernetes est de le laisser fonctionner sur ses propres noeuds, sans autre logiciel, y compris les systèmes de stockage distribués.

StorPool ambitionne de simplifier cette couche d'infrastructure en venant remplacer des solutions jugées obsolètes. (Crédit StorPool)

Si la solution de Stopool se destine avant tout aux MSP, elle peut également intéresser les entreprises qui disposent de solides compétences Linux. Dans l'infographie ci-dessus, la start-up dresse un état du marché qu'elle adresse : du Tier 0 au Tier 3 pour répondre à des besoins comme le big data, les applications conteneurisés mais également leur sauvegarde. D'origine bulgare, Stopool est bien implanté en Europe et revendique des clients comme Siemens, Deutsche Börse Group, l'Agence Spatiale européenne et le Cern.